Пустые страницы на сайте чем грозят

Повлияет ли на выдачу «пустые» страницы на сайте?

Делаем редизайн сайта, в котором много страниц товаров. Хочется сперва освежить дизайн, а потом занятся SEO текстами на каждую страницу. Будет ли какой то негативный эффект, если сперва страницы будут без текста, проиндексируются, а потом в течении нескольки месяцев будет добавлятся текст?

И еще, дизайн в минималистическом стиле, поэтому SEO текст находится под катом по кнопке ‘показать текст’ в конце страницы перед подвалом. Видел такое на нескольких успешных сайтах, но будет ли такой текст нормально учитываться поисковиками?

Будет ли какой то негативный эффект, если сперва страницы будут без текста, проиндексируются, а потом в течении нескольки месяцев будет добавлятся текст?

Для поисковых систем однотипные страницы без контента не представляют ценности, они могут подолгу их не индексировать. И не забывайте, переидексация процесс не быстрый (особенно для яндекса), в Вашей ситуации времени она может потребовать еще больше чем индексация.

Повлияет ли на выдачу «пустые» страницы на сайте?

Плюсом наличие таких страниц не будет точно, поисковики вполне могут проигнорировать их.

И еще, дизайн в минималистическом стиле, поэтому SEO текст находится под катом по кнопке ‘показать текст’ в конце страницы перед подвалом. Видел такое на нескольких успешных сайтах, но будет ли такой текст нормально учитываться поисковиками?

Пустые страницы на сайте и SEO

Пустые страницы — это страницы без контента. Такие страницы содержат только часть интерфейса (шапка, меню, футер) без полезного содержимого.

К тому же у пустых страниц одинаковое содержимое (интерфейсная часть на всех страницах одинаковая), то есть они являются еще и дубликатами. Это тоже негативно влияет на ранжирование сайта поисковиками.

Как проверить наличие пустых страниц на сайте

Чтобы найти пустые страницы на сайте, можно воспользоваться одним из перечисленных способов.

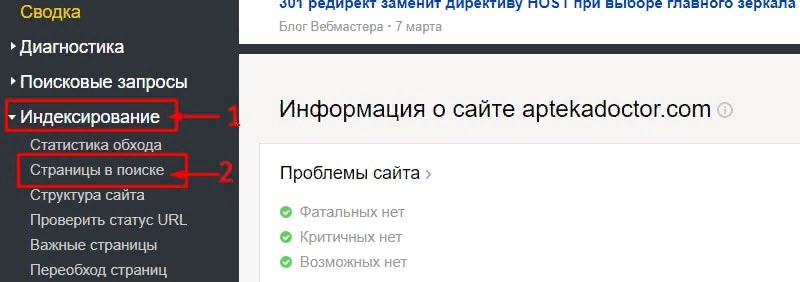

1. Сервисы Яндекс.Вебмастер и Google Search Console

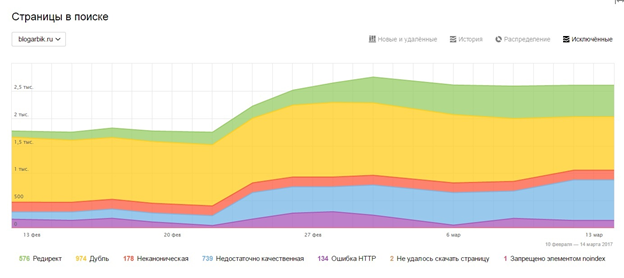

В Вебмастере нужно зайти в раздел «Индексирование» — «Страницы в поиске». Будет показан полный перечень страниц сайта, включая URL, попавшие в индекс и исключенные из поиска. Среди них нужно обращать внимание на страницы с малым весом (менее 3 кб) — это признак пустой страницы.

В Search Console нужно перейти в раздел «Покрытие» и получить отчет об индексировании. В нём также будет представлен список страниц сайта для анализа. По заголовку и url можно проверить, имеет ли страница полезный контент.

2. Сайты, предоставляющие услуги по аудиту сайта. В большинстве своем это платная услуга. Например, такую услугу предлагает сервис serpstat.ru. В отчете после аудита сайта будет показана категория «Страницы, на которых мало текста». Их нужно проверить, действительно ли это пустые страницы, и затем принять решение, что с ними делать.

3. Программы-краулеры. Они сканируют сайт и выдают отчет о его структуре и других параметрах. Например, программа Screamingfrog к каждому URL показывает такой параметр как «Word Count» («Количество слов»). Если он стремится к нулю, то эта страница считается пустой.

4. Если сайт небольшой, то можно в поисковой строке Google ввести site: и адрес сайта. Гугл покажет все проиндексированные страницы. Про анализируйте их — возможно среди них есть пустые страницы.

Что делать с пустыми страницами

Наша задача — чтобы в индексе поисковиков были только полезные нужные страницы. Пустые страницы мешают продвижению сайта.

Наша почта:

Единая справочная: 8 (843) 2-588-132

WhatsApp: +7 (960) 048 81 32

Оставить заявку

Чем грозит дублированный контент, пустые страницы и ошибки на сайте для вашего бизнеса?

Что делать, если на Вашем сайте есть дублированный контент?

Дублированный контент — распространённая проблема. Нередко в описании товаров и услуг на разных сайтах можно встретить одинаковые фразы, целые предложения и даже тексты. Это неизбежно, особенно в высококонкурентных нишах (например, пластиковые окна или услуги в сфере недвижимости).

Возникает логичный вопрос: «Будет ли Google наказывать мой сайт за дублированный контент?

Просто и однозначно ответим: да

Google и другие поисковики хотят от сайта действительно уникальный контент. Если на странице есть дублированный контент, Google в первую очередь будет искать первоисточник. И только первоисточник получит доверие поисковика.

Итак, какие ошибки могут встречаться на сайте и как их избежать? Несколько действенных советов

Google «считает», что дублированный контент может использоваться для манипулирования поисковиком и поднятия рейтингов в выдаче, для обмана пользователей. И сайт неизбежно будет ранжироваться хуже. И больше того — может быть полностью удалён из результатов поиска».

На что может повлиять дублированный контент?

Каждая страница сайта должна быть оптимизирована с использованием уникального контента.

Для улучшения внутренней структуры сайта каждая страница должна содержать уникальное описание каждого продукта.

Некоторые владельцы сайтов во избежание дублированного контента используют минимальную информацию о товаре: название, цену, категорию. Но это ещё хуже, чем дублировать чужую информацию. Ведь если на странице совсем нет контента, у Google могут возникнуть проблемы с идентификацией того, что на самом деле содержится на странице. Если Google не сможет понять вашу страницу, он не сможет перенаправить её в поисковой выдаче тем пользователям, которые ищут схожие с вашими товары и услуги.

На целевой странице должно быть не менее 500 слов. Если не получается — хотя бы 250 слов.

Использование этих методов позволяет уйти от дублированного контента на сайте. Тем самым вы избежите штрафов со стороны поисковых систем. Увеличивается вероятность того, что пользователи будут направлены на главную страницу сайта из результата поиска.

Могу ли я просто скрыть дублированный контент на моём сайте?

Если на сайте присутствует дублированный контент, некоторые эксперты могут посоветовать скрыть его в тег «noindex».

Однако мы должны предупредить о недостатках noindex.

В первую очередь, noindex означает, что текст не будет отображаться в результатах поиска. То есть никто не найдет вашу страницу, если не придёт непосредственно на сайт.

Кроме того, за дублированный контент Google может наложить штраф на ваш сайт.

Что делать, если у меня нет времени или я не такой красноречивый, чтобы создать уникальный контент?

Если вам нужна помощь в написании уникального контента на сайт, обратитесь в нашу компанию. Мы предоставляем услуги по копирайтингу для наших клиентов, а также поможем избавиться от дублированного контента, чтобы ресурс не попал под санкции поисковых систем.

Определения и рекомендации для исправления ошибок на сайте, а также пустых страниц и дублированного контента

1. Дублированный контент

Дублированный контент – это страницы сайта, одинаковые по содержанию и наполнению. Дубли бывают двух видов:

● Полные ― контент на страницах полностью совпадает;

● Частичные ― наполнение страниц одинаковое, но не в полной мере, есть различные элементы.

Не всегда дублированный контент используют в корыстных целях, он может присутствовать, к примеру, на страницах форума как в версиях сайта для десктопов, так и для мобильных устройств; в описании товаров и услуг интернет-магазинов, которые показываются при переходе по разным URL и т.д.

Внутренний дублированный контент может караться поисковыми системами вплоть до штрафов. «Двойниками» считаются страницы для печати, архивы, идентичные элементы (к примеру, две картинки, различные в коде только по названию).

Как решить проблему? Найдите дублированный контент и удалите его или сделайте невидимым для поисковых роботов. Есть несколько способов увидеть «двойников», например, с помощью сервиса saitreport.ru). Вам нужно только выбрать подходящий для вас. Если не хотите удалить страницу, а предпочитаете скрыть её, то лучше сделать это с помощью robots.txt или мета тега.

Почему дубли страниц негативно сказываются на ранжировании сайта?

Поисковые системы воспринимают дубли как отдельные страницы сайта, поэтому они уже становятся неуникальным. Ссылочный вес страницы понижается. Сайты, содержащие более 50% дублированного контента, могут быть понижены в поисковой выдаче.

Мы уже писали о том, что в феврале 2015 года Джон Мюллер во время видеоконференции заявлял, что дублированные теги title и метаописания не попадают под санкции алгоритма «Панда». Их присутствие не сильно отразится на качестве поиска. Несмотря на то, что алгоритм «Панда» не будет наказывать сайт за дублированный контент, владельцам сайтов и веб-мастерам специалист Google всё же рекомендовал удалять дублированное содержимое.

В Яндексе дублированный контент может привести к попаданию под фильтры, например, «АГС», схожий с Panda. Яндекс может удалить из индекса поисковика страницы, содержащие дублированный контент, а новые страницы — не индексировать. Сайты, которые содержат скопированный контент, расцениваются поисковиком как дубликаты, а не как первоисточники информации. Дублированный контент может негативно повлиять на позиции сайта — Яндекс понизит его в поисковой выдаче и число переходов со страницы выдачи снизится. В некоторых случаях — до нуля.

Своим мнением поделился генеральный директор Optimism.ru Роман Клевцов: «Дублирование страниц на сайте ― это однозначно отрицательное явление, от которого нужно всячески избавляться. Хорошим вариантом для вас будет уникализация контента с помощью упоминания в тексте специфических названий, адресов (ЦАО, СЗАО), ГЕО. Конечно, если Вы создаёте разный контент с учетом ключевых слов специально подобранных для данного региона – это увеличивает шансы выхода в ТОП, но все зависит еще и от самого сайта. Например, если вы продвигаете интернет-магазин или региональный портал, то вполне можете изменять упоминания региона только в заголовках и мета. Обязательно нужно отслеживать, чтобы на страницах таких сайтов были карточки товара или объявления, актуальные для данного региона. Другими словами, все зависит от специфики вашего бизнеса. Сайт сможет быть на лидирующих позициях в выдаче, если на нем будет размещен актуальный контент».

2. Пустые страницы на сайте

Каждая страница на сайте должна нести смысловую нагрузку. Пустые страницы не содержат никакой информации (пустой форум, пустые профили пользователей и т.д.).

Не рекомендуется оставлять их в индексе, лучше скрывать в файле robots.txt. Если таких страниц много, то это негативно сказывается на продвижении и лояльности посетителей и поисковых роботов к сайту.

Какие ещё ошибки могут привести к понижению позиций?

3. Некачественные заголовки и описания

Заголовки страниц должны быть высокого качества и релевантными содержанию страницы, поскольку они представляют лицо сайта. В теге title заголовок прописывают так, чтобы с первого же прочтения было понятно, о чём страница. Описание под заголовком также составляют «для людей». Это даст возможность улучшить кликабельность сниппета в поисковой выдаче.

4. Чрезмерное употребление ключевых слов на странице

Переоптимизация страниц сайта ключевыми словами ― грубая ошибка и фактор, за который поисковые роботы могут понизить ресурс в выдаче, а пользователи, скорее всего, уйдут с сайта, поскольку читать тексты с высокой плотностью слов, как минимум, неудобно и неприятно. Не стоит злоупотреблять большим количеством ключевиков, они должны быть строго на своих местах: обычно это заголовки и подзаголовки, мета теги, подписи к изображениям и т.д.

В блоге Яндекса сказано, что поисковик отдаёт предпочтение сайтам, которые созданы для людей и удобны пользователям, и негативно относится к попыткам повысить релевантность страниц за счёт чрезмерного употребления в текстах ключевых слов. Размещение переоптимизированного контента, который не адресованы посетителям сайта, относится к приёмам «псевдооптимизации» и не улучшает качество сайта. Если поисковой робот определит, что контент создан для поисковой системы и повышения релевантности, позиции этой страницы в выдаче могут ухудшиться.

5. Отсутствие карты сайта и файла robots.txt

Карта сайта ― это важный элемент навигации, представляет некое оглавление страниц ресурса и помогает пользователям лучше ориентироваться на сайте, а вебмастерам ― даёт возможность использовать её при индексации больших сайтов.

Robots.txt — текстовый файл, содержащий критерии индексирования сайта для роботов поисковых систем. Если файл robots.txt настроен правильно, то он помогает избежать проблем с дублированием контента и т.д.

6. Использование клоакинга

Клоакинг ― (от англ. cloak — маска, прикрытие) — это подмена контента, при которой поисковому роботу выдаётся одна информация, а пользователю другая. За это все поисковики строго наказывают сайты. К клоакингу так же относятся: текст под цвет фона, display:none и т.п.

7. Неправильная перелинковка

Не рекомендуется делать перелинковку с помощью плагинов. Желательно вручную проставить ссылки на другие статьи, поскольку поисковой робот может не всегда учитывает такие ссылки.

8. Ошибки, связанные с использованием ссылок

Битые ссылки ― ссылки, перейдя по которым пользователь видит пустую страницу с надписью «ошибка 404», то есть несуществующую страницу. Их ещё называют «ссылками в никуда». Поисковики не любят сайты с битыми ссылками и может строго их наказывать, понижая в выдаче. Google считает, что наличие битых ссылок — свидетельство того, что за ресурсом никто не следит или он совсем заброшен. Рекомендуется найти и убрать подобные ссылки с сайта, если они есть. Это касается не только ссылок в пределах одного ресурса, но и ведущих на внешние сайты.

● Исходящие ссылки на «плохие» сайты

В блоге Яндекс.Вебмастер указано, что исходящие ссылки на некачественные сайты (немодерируемые форумы, доски объявлений, содержащие большое

количество ссылочного спама) — поисковик старается не индексировать или не ранжировать высоко. Стоит иметь ввиду, что подобные сайты достаточно быстро вылетят из индекса, если ошибки не будут исправлены.

● На страницы сайта нет ссылок

Бывает так, что страница сайта существует, но на неё не ведёт ссылка или индексируемая страница подписки. В этом случае лучше такие страницы закрыть от индексации.

● С одной страницы на другую ведут сразу несколько ссылок

Не рекомендуется допускать, чтобы на сайте присутствовали 2-3 и более ссылок, которые ведут на одну и ту же страницу в пределах сайта.

● Переизбыток ссылок со страницы

Ошибкой в оптимизации сайта также считается, когда ссылок в пределах одной странице слишком много. Яндекс рекомендует не превышать лимит в 100 ссылок с одной страницы.

Каноническая страница сайта — страница, которая доступна по нескольким URL-адресам, то есть на неё ведут разные ссылки. В этом случае, чтобы поисковые роботы не понизили сайт в выдаче, рекомендуется прописать для такой страницы каноноческий адрес, основной. Это делают с помощью метатег canonical.

О чём говорит статистика?

А теперь для наглядности обратимся к статистическим данным. По ним видно, насколько (в %) сайт может потерять позиции при той или иной ошибки.

Ошибки оформления текстового контента

Ошибки в использовании ключевых слов

Другие факторы, понижающие позиции сайта в выдаче

Ещё немного полезной информации по теме в нашем блоге:

Что такое страница низкого качества?

Страницы низкого качества с точки зрения поисковых систем (ПС) — это те, которые не дают четкого ответа на запрос пользователя и, соответственно, не несут в себе никакой ценности и полезной информации. Вероятность того, что они появятся в поиске, практически равна нулю.

Обнаружив у себя такие, не стоит в панике ставить на них штамп «все фигня, переделывай», удалять их или настраивать 301 редирект. Сперва необходимо выяснить причину исключения из поиска, а уже затем действовать по ситуации.

Как обнаружить у себя подобные страницы?

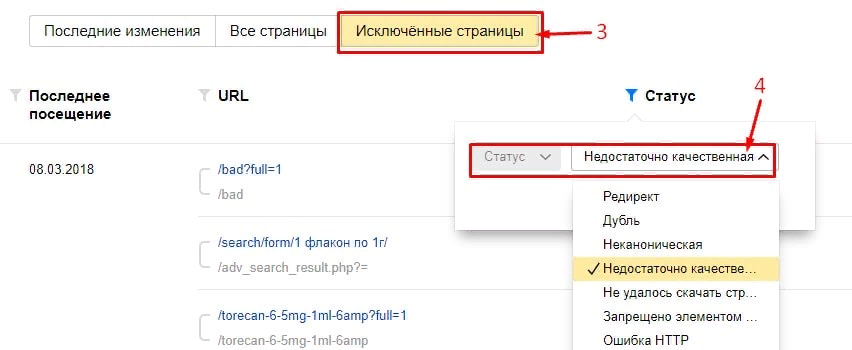

Открываем «Индексирование» —> «Страницы в поиске», затем во вкладке «Исключённые страницы» устанавливаем статус «Недостаточно качественная».

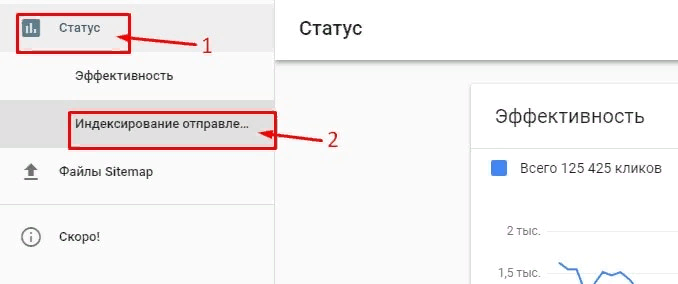

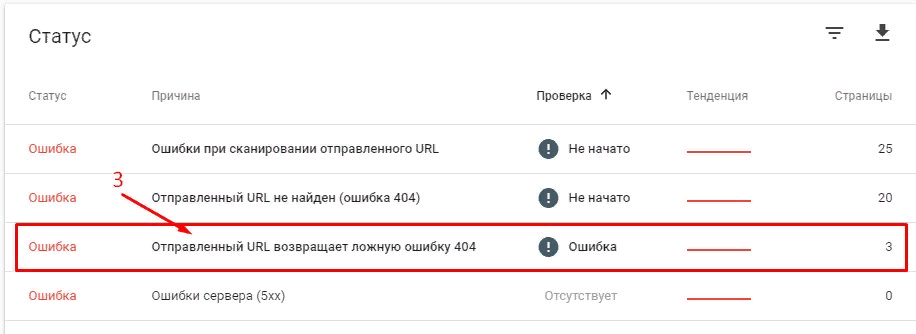

К сожалению, этот инструмент не показывает, какие именно страницы были удалены из-за качества. Но можно пойти на хитрость: просмотреть страницы, выдающие «Отправленный URL возвращает ложную ошибку 404». Если при этом страницы существуют, а сервер дает некорректный ответ, это признак их низкого качества.

Итак, как найти страницы с ложной ошибкой 404:

Открываем в боковом меню Google Search Console «Статус» —> «Индексирование отправленных URL» и выбираем строку «Отправленный URL возвращает ложную ошибку 404», после чего вручную анализируем страницы.

Влияют ли низкокачественные страницы на позицию сайта в поиске?

В идеале, как бы много некачественных страниц на сайте ни было, они не должны влиять на ранжирование остальных. Однако в реальности большое их количество может заставить ПС сомневаться в надежности ресурса, на котором встречаются как качественные страницы, так и не очень, и это может снизить позицию всего сайта в целом.

Причины удаления страницы из поиска

Это может происходить как из-за технических неполадок, которые достаточно легко быстро устранить, так и потому, что действительно имеются проблемы с качеством.

Чтобы найти исключенные страницы, открываем Яндекс.Вебмастер и переходим в раздел «Индексирование» и смотрим, что он нам даст:

1. Редирект и дубли

Часто под категорию некачественных страниц попадают их дубли. Поисковик по какой-то причине считает их более релевантными, чем оригиналы. В этом нет ничего страшного — это естественная составляющая работы сайта.

2. Слишком большое количество страниц по одному запросу

Скажем, вы владелец интернет-магазина. У вас на складе есть платья одного фасона, но пяти разных цветов. Что вы делаете? Правильно: создаете отдельную страницу для каждого цвета платья (на самом деле нет). С одной стороны, это удобно для клиентов, но с другой снижает релевантность для ПС.

Разумеется, качество наполнения более важно, чем его количество, однако не стоит оставлять страницы абсолютно пустыми. Если, конечно, для вас важно, чтобы они выходили в поиске.

4. Неуникальные страницы

Если любите копипасту и шаблоны, будьте готовы к тому, что пользователи никогда не узнают о существовании ваших товаров, так как не найдут в поиске. В этих случаях могут быть проблемы с неуникальными Title, Description, заголовками и подзаголовками.

5. Некорректный ответ сервера

Это могут быть реально отсутствующие или пустые страницы, а также те, при переходе на которые должен выдаваться ответ 404, но вместо этого выходит 200 OK.

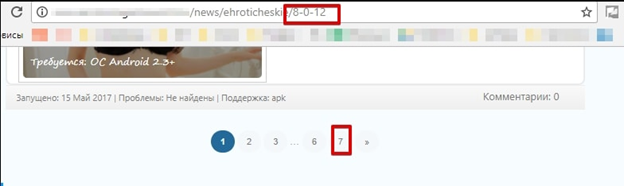

Здесь, например, Яндекс исключил из поиска восьмую страницу, хотя на самом деле существует всего 7:

6. Страницы пагинации и сортировки, GET-параметры

Это может происходить из-за того, что для них не настроены уникальные страницы.

Если вы переезжаете на защищенный протокол, но не настраиваете 301 редирект, ПС просто не знает, что с ней делать, и удаляет как некачественную.

8. Страница закрыта с помощью robots.txt

ПС не всегда следуют указаниям из этого файла.

9. Создание пустых страниц категорий

Скажем, вы открыли в своем интернет-магазине категорию «Фоторамки ручной работы», а товары в нее еще не добавили. Такие страницы ПС будет удалять, потому что на них много отказов и они нерелевантны.

10. Страницы, не предназначенные для поиска

Сюда относятся файлы robots.txt, Sitemap и ленты-RSS. Они попросту не нужны в поиске, и за них не стоит переживать.

11. Технические ошибки в оформлении страницы

Скажем, вы решили вывесить всплывающее окно, сообщающее, что в этом месяце предлагаете скидку 25% на всю бытовую химию по промокоду «CHISTO», но в результате ошибки баннер перекрыл всю страницу, а закрыть ее невозможно. ПС плохо относятся к таким страницам и удаляют их.

Как исправить недостаточно качественную страницу

Каждый тип ошибки требует соответствующего решения.

Дубли

Так как в этом случае страница повторяет уже существующую, указываем роботу предпочтительный адрес с помощью 301 редиректа или rel=«canonical». После этого не забудьте добавить обе страницы в переобход робота.

Слишком большое количество страниц

Проверяем, приносят ли они трафик. Если нет, лучше представить вариации товара на одной, а лишние удалить.

Недостаточная заполненность страницы

Здесь все просто: если она необходима для поиска, заполняем ее качественным уникальным контентом. В противном случае настраиваем метатег noindex.

Неуникальные страницы

Отказываемся от шаблонов и заполняем страницу уникальным текстом и картинками, не забывая о корректном вводе Title, Description, заголовков и подзаголовков.

Некорректный ответ сервера

Исправляем технические недочеты, если страницы нужны, настраиваем noindex. В противном случае — ответ сервера 404.

Это основные проблемы и способы их решения, однако каждый случай по-своему уникален, и иногда требуется индивидуальное рассмотрение.

В целом не стоит бояться появления подобных проблем, ведь это в первую очередь сигнал для вас, что с сайтом что-то не так и он мог бы работать эффективнее. Работайте над ошибками, наполняйте сайт качественным уникальным контентом, и будет вам счастье.

С какими проблемами с недостаточно качественными страницами вы сталкивались и как их решали? Делитесь в комментариях!

Ошибки в оптимизации сайта

Ни кто не застрахован от ошибок, в любых делах. Это касается и оптимизации сайтов. Вебмастера допускают разные ошибки оптимизации сайтов, от не значительных, до довольно серьезных.

Серьезные ошибки могут привести к плохому ранжированию страниц, к медленно и неполной индексации сайта и т.д. Приведу примеры самых распространенных ошибок при оптимизации страниц.

Первая ошибка: некачественный заголовок и описание

До сих пор часто встречаются некачественно сделанные заголовки страниц. В тег Title пишут абы что, чаще всего это перечень ключей, который не читабельный. Запомните, заголовок это лицо сайта. Это первое что видит юзер в поиске. Что писать в Title почитаете по ссылке. Далее — описание под заголовком. На него тоже мало кто уделяет внимание, а зря. Оптимизируя его можно добиться улучшения кликабельности вашего сниппета в поиске.

Вторая ошибка: нерелевантный заголовок.

Я разделил это на два разных пункта. Так как можно написать некачественный заголовок, но по теме. А можно написать красивый, но нерелевантный содержимому страницы. Грубо говоря вы решили собрать в вашем тайтле все трафиковые ключи, а на странице этот вопрос не раскрыт. И юзер перейдя по вашему привлекательному заголовку на сайт увидит, что его обманули и уйдет. Вам сразу пойдет минус в поведенческие факторы.

Третья ошибка: пустые страницы на сайте.

Некоторые думают, что чем больше страниц на сайте, тем лучше. В целом это так, но они должны нести смысловую нагрузку. Не стоит держать в индексе пустые страницы, различные служебные страницы, скрипты и прочее. Закрывайте все это от индексации в robots.txt. Или получите еще один минус в «карму» вашего сайта. Минимум 500 символов на страницу.

Четвертая ошибка: переоптимизация текста ключевыми словами.

Следующая ошибка в оптимизации страниц сайта это чрезмерное употребление ключевых слов. Предложения становятся противными к чтению. От таких текстов тошнит и юзеров и поисковые системы. Не злоупотребляйте излишним количеством ключевиков. Можете прочитать как проверить плотность ключей.

Пятая ошибка: недостаточная оптимизация контента.

Если в прошлом пункте шла речь о чрезмерном использовании ключей, то в этом их о недостатке. Не забывайте использовать все значимые места на странице, где можно упомянуть продвигаемые ключи. Это заголовки и подзаголовки, мета теги, подписи к картинкам и т.д. Подробно мы рассматривали этот вопросы в прошлых статьях.

Шестая ошибка: избыток рекламных баннеров

В последнее время поисковики ревностно относятся к большому обилию рекламных материалов размещенных на сайтах. Да и пользователям не нравится, когда из-за обилия мигающих рекламных баннеров, не видно основного контента.

Седьмая ошибка: отсутствие карты сайта и robots.txt

Большое количество вебмастеров пренебрегают советами по использованию карты сайта. А зря, она очень помогает при индексации больших сайтов. Кроме того, правильно настроенный файл robots.txt помогает избежать многих проблем с дублированием контента.

Использование клоакинга

Что бы не хотели сделать в конечном итоге, ни когда не делайте клоакинг на СДЛ сайте. Клоакинг – это подмена контента, когда поисковому роботу выдается одна информация, а юзеру другая. Все поисковики за это жестко наказывают сайты. К клоакингу так же относится текст под цвет фона, display:none и другие более изощренные методы.

Размещение линкопомойки на сайте

Подобный пережиток прошло уже мало где встречается, но имеет место быть. Ни когда не делайте каталога ссылок для обмена с другими сайтами. Это и есть линкопомойка.

Переходим к следующему разделу Индексация сайта