зачем видеокарта в компьютере кроме игр нужна

Для чего и зачем нужна хорошая видеокарта в компьютере кроме игр?

Привет, друзья! Компьютер, как известно, не просто навороченный медиацентр с выходом в интернет и возможностью запуска интереснейших игр – многими он используется и для работы. Сегодня обсудим тему, для чего нужна мощная видеокарта кроме игр и где используется еще такое устройство.

Майнинг криптовалют

Процесс добычи биткойнов и прочих Эфириумов скакнул далеко вперед. Видеокарты постепенно уступают место майнерам – специальным устройствам, которые при меньшем энергопотреблении дают более высокий хешрейт. Однако, это не мешает многим работать «по старинке», создавая фермы из нескольких мощных графических ускорителей.

Это стало причиной некоего дефицита видеокарт, особенно тех, что относятся к классу топовых устройств.

К сожалению, это же и стало причиной появления на рынке огромного числа таких девайсов, бывших в употреблении: после нескольких лет нещадной эксплуатации, такой графический ускоритель не отправляется на покой, а продается с целью «отбить» определенную сумму. Не рекомендую связываться – покупаете «кота в мешке».

Обучение и медицина

Использовать шлем виртуальной реальности в связке с мощным компьютером, в целях обучения иногда выходит дешевле: например, представьте, сколько нужно обучать пилота, чтобы он отлетал положенное количество часов.

А теперь посчитайте, сколько керосина при этом он сожжет и сколько это может стоить. Конечно, обучение с помощью VR – не полная замена, но неплохая помощь в процессе.

Согласно последним исследованиям ученых, использование специальных пространств виртуальной реальности позволяет бороться с некоторыми расстройствами мозга и нервной системы – например, старческой деменцией или проблемами вестибулярного аппарата.

Работа с графикой

Сюда можно включить не только моделирование 3D-объектов с помощью инженерных конструкторов, но и, казалось бы, такие тривиальные задачи, как обработку фотографий – новые версии Photoshop очень требовательны к мощности компа.

С другой стороны, зачем эти «излишества», если вы занимаетесь этим раз в году?

Видеомонтаж

Хороший видеоредактор – необходимый рабочий инструмент любого видеоблогера, видеографа или монтажера. Почти всегда, отснятый материал требует дополнительной обработки, особенно удаления лишнего, а также вставки различных эффектов.

Проведение стримов

Некоторые ошибочно полагают, что стримят только прохождением какой-либо игры. Отнюдь. При наличии фантазии, прямой эфир можно превратить в шоу – например, троллить народ в «Чат-рулетке» или провести сеанс ASMR-терапии.

Естественно, таким стримерам нужны хорошие, дорогие вебкамеры для трансляции качественного изображения, справиться с которым может только мощный GPU.

Вот в принципе, все задачи, которые мне удалось вспомнить. Если вам еще что-то пришло на ум, не стесняйтесь и пишите в комментариях.

А еще советую вам почитать публикации «Встроенная и интегрированная графика в процессоре» и «Выбираем процессор для домашнего компьютера». А о процессорах для рендеринга за 2017 и 2018 год вы можете узнать здесь.

Спасибо за внимание и до встреч на страницах моего блога! Не забудьте поделиться этой публикацией Вконтакте или Фейсбуке и подписаться на обновления.

Для чего нужна видеокарта: ликбез для новичков

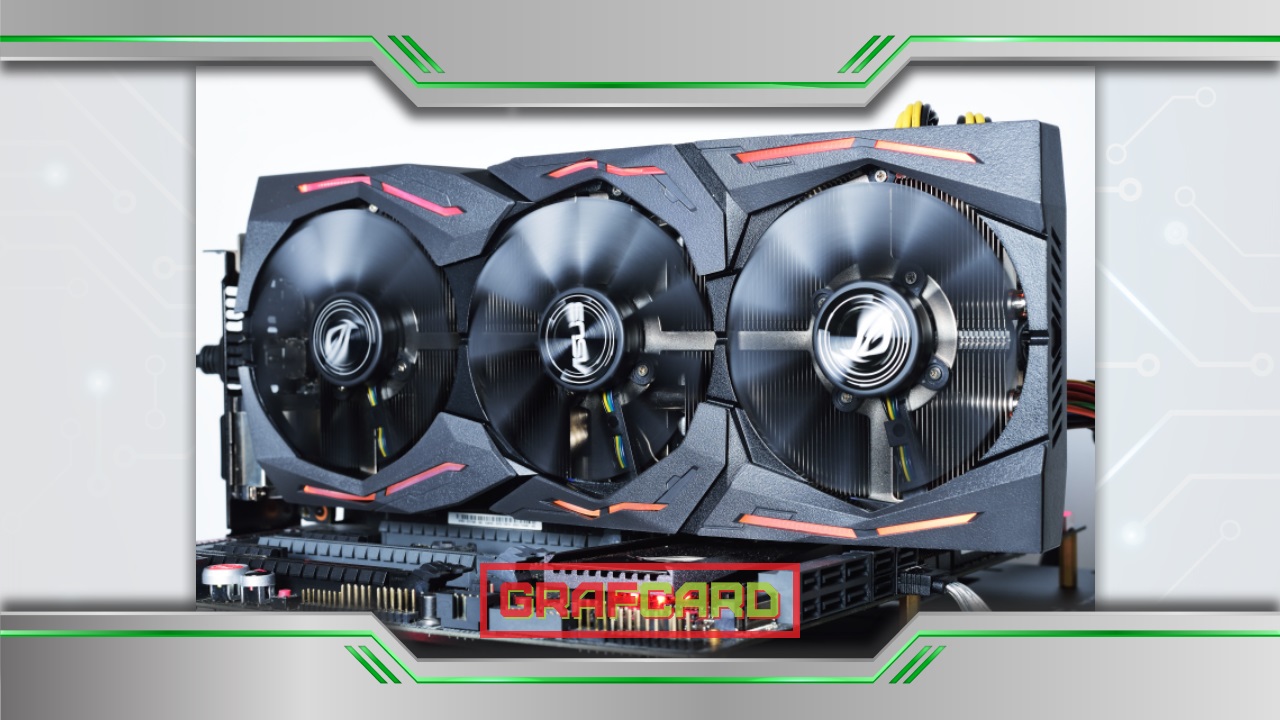

Как выглядит видеокарта?

Видеокарта — это неотъемлемая составляющая любого компьютера, из-за отсутствия которой изображение на монитор не передавалось бы. Её еще называют графическим ускорителем, задача которого состоит в передачи неисчисляемого количества мегабайт информации на монитор. Поэтому совсем не удивительно, что такая плата занимает второе место по размеру среди всех компонентов компьютера.

Разные производители разрабатывают разный дизайн такого модуля. А также они могут быть как встроенными, так и дискретными.

На протяжении долгого времени встроенная видеокарта выглядела как находящиеся на материнской плате элементы модуля вместе с графическим процессом. Из-за этого она отбирала часть оперативной памяти. Сегодня такая видеокарта представляет ядро, которое размещено в самом центре процессора. Это небольшой графический чип. Из-за скрытого местоположения и маленького размера, обнаружить такой чип будет сложно.

Дискретная же видеокарта выглядит как отдельная плата, которая имеет свою оперативную память и графический процессор. Такой модуль находится в системном блоке и установлен на материнской плате. Из-за своего большого размера не заметить его невозможно. Расположенная в ноутбуке, она имеет небольшие размеры.

Где находится видеокарта?

Чаще всего необходимость в поиске видеокарты возникает в случае замены старого видеоадаптера на новый или же в случае скопления пыли, которую нужно вычистить.

Определить видеокарту не составит труда, так как она имеет систему охлаждения, которая похожа на вентилятор. Ее уж ни с чем не спутаешь. Видеокарту устанавливают для того, чтобы не случился перегрев и поломка модуля. Такая карта может иметь в наличии один или два кулера.

Иногда, возникают трудности с месторасположением видеоадаптера. Ведь система охлаждения может быть замаскирована, а в материнской плате установлено еще пару модулей. Исключительно каждый адаптер имеет разъемы VGA для того, чтобы подключить монитор. Он легко выделяется среди других составляющих, так как имеет ярко выраженный синий (реже белый) цвет и прямоугольную форму. Перепутать такие разъемы будет крайне тяжело, а обнаружив их, вы сразу поймете, что перед вами видеоадаптер.

Для чего нужна видеокарта

Видеоадаптер служит для того, чтобы рассчитать изображение и вывести его на экран монитора. Иначе говоря, она формирует всё, что вы видите на экране. Это и является ее основной функцией. Но помимо этого, она использует свои возможности в проведении вычислений в таких задачах, которые не прямо не связанны с этими функциями.

На что влияет видеокарта

Главным фактором при выборе видеокарты для компьютера является количество объема памяти. Ведь именно размер памяти видеокарты влияет на программы, работающие с видеопамятью (игры, например). А если памяти будет не хватать, могут возникнуть проблемы (к примеру, непрорисовывание текстур).

Чем отличаются видеокарты

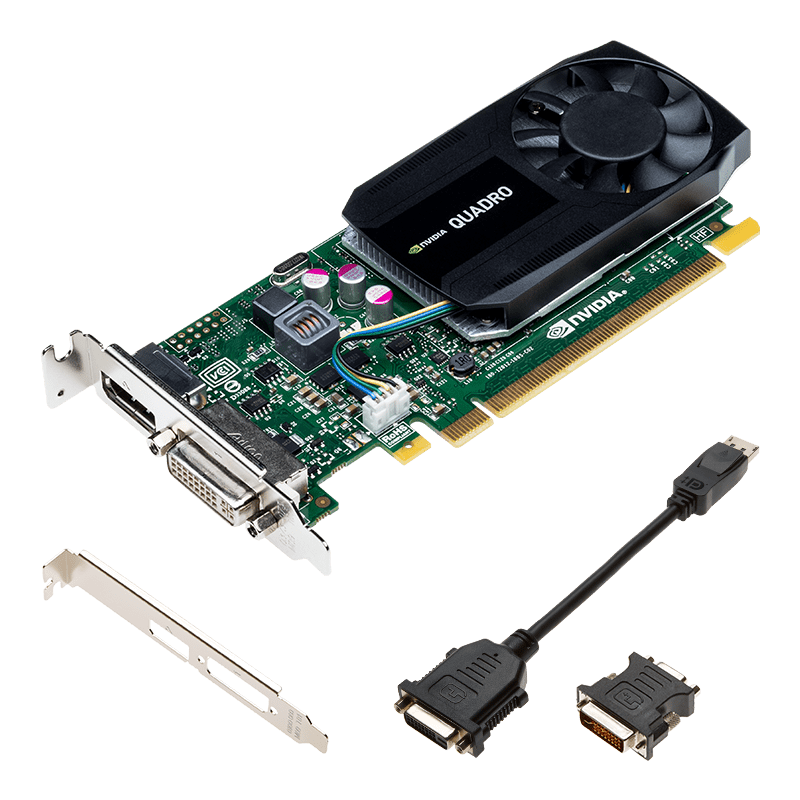

Существует несколько видов видеокарт. Их различают на офисные, игровые и профессиональные. Первые — это простые графические видеоадаптеры, которые предназначаются для того, чтобы выводить изображение на монитор. Это происходит в процессе работы с программами, которые являются нетребовательными к ресурсам. Но в чем же отличие профессиональной видеокарты от игровой?

Говоря простым языком, в развлекательных приложениях и играх важным является изображение, эффекты и окончательная картинка всего этого. Профессиональные же адаптеры дают высокую производительность в специфических задачах, например моделирование и работа с инженерным софтом. Поэтому требования, которые выдвигают для видеокарт в первом случае, связаны со скоростью создания текстур и быстродействием шейдеров. Для вторых же важна геометрическая производительность процессора.

Зачем нужна видеокарта

В современном мире многие слышали о таком понятии, как видеокарта. Не очень опытные пользователи могли задаться вопросом, что это такое и зачем нужно это устройство. Кто-то может не придавать графическому процессору особого значения, а зря. О важности видеокарты и о функциях, которые она выполняет в определенных процессах, вы узнаете в этой статье.

Зачем нужна видеокарта

Видеокарты являются связующим звеном между пользователем и ПК. Они переносят информацию, обрабатываемую компьютером, на монитор, тем самым способствуя взаимодействию между человеком и ЭВМ. Кроме стандартного вывода изображения, данное устройство выполняет обрабатывающие и вычислительные операции, в некоторых случаях, разгружая этим процессор. Давайте подробнее рассмотрим действие видеокарты в разных условиях.

Основная роль видеокарты

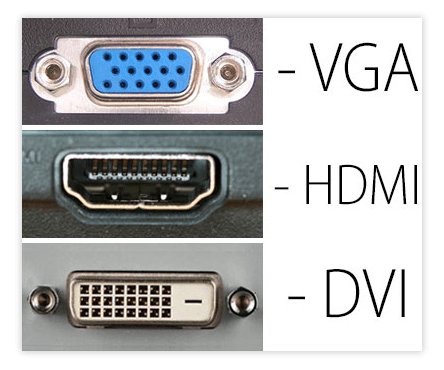

Вы видите изображение на своем мониторе благодаря тому, что видеокарта обработала графические данные, перевела их в видеосигналы и отобразила на экране. Современные видеокарты (GPU) являются автономными устройствами, поэтому разгружают оперативную память и процессор (CPU) от дополнительных операций. Нельзя не отметить, что сейчас графические адаптеры позволяют подключить монитор с помощью различных интерфейсов, поэтому устройства осуществляют преобразование сигнала для активного типа подключения.

Подключение через VGA постепенно устаревает, и если на видеокартах еще встречается этот разъем, то на некоторых моделях мониторов он отсутствует. DVI немного лучше передает изображение, однако неспособен принимать звуковые сигналы, из-за чего уступает подключению через HDMI, который совершенствуется с каждым поколением. Самым прогрессивным считается интерфейс DisplayPort, он похож на HDMI, однако обладает более широким каналом передачи информации. На нашем сайте вы можете ознакомиться со сравнением интерфейсов подключения монитора к видеокарте и выбрать подходящий для себя.

Кроме этого стоит обратить внимание на интегрированные графические ускорители. Поскольку они являются частью процессора, то подключение монитора осуществляется только через разъемы на материнской плате. А если вы обладаете дискретной картой, то подключайте экраны только через нее, так вы не будете задействовать встроенное ядро и получите большую производительность.

Роль видеокарты в играх

Многие пользователи приобретают мощные видеокарты исключительно для запуска современных игр. Графический процессор берет на себя выполнение основных операций. Например, для построения видимого игроку кадра происходит просчет видимых объектов, освещения и постобработка с добавлением эффектов и фильтров. Все это ложится на мощности GPU, а CPU выполняет лишь малую часть всего процесса создания изображения.

Из этого и получается, что чем мощнее видеокарта, тем быстрее происходит обработка необходимой визуальной информации. Высокое разрешение, детализация и остальные настройки графики требуют большое количество ресурсов и времени на обработку. Поэтому одним из самых важных параметров при подборе является объем памяти GPU. Более подробно о выборе игровой карты вы можете почитать в нашей статье.

Роль видеокарты в программах

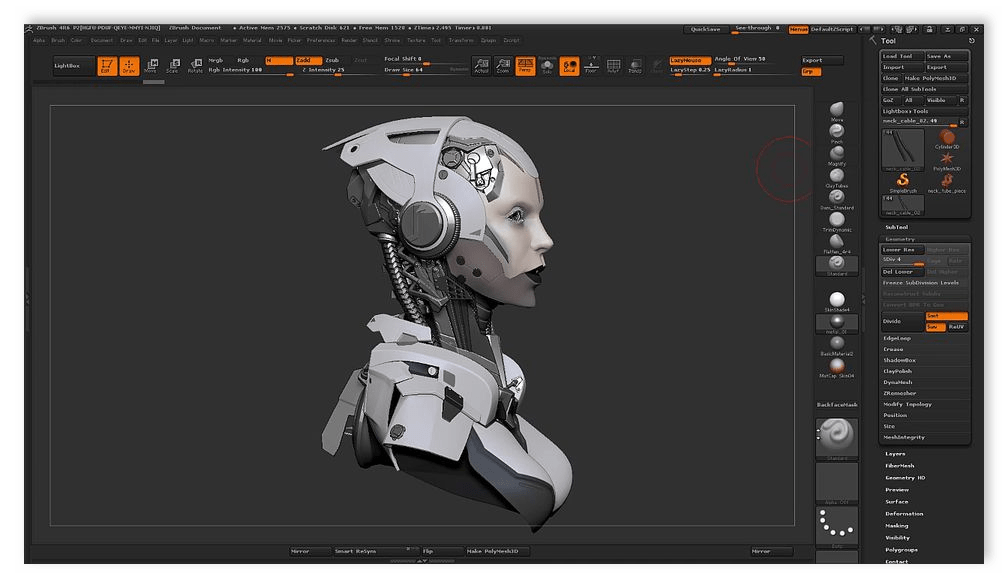

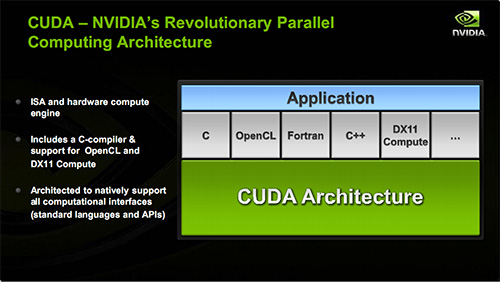

Ходят слухи, что для 3D-моделирования в определенных программах необходима специальная видеокарта, например, серии Quadro от Nvidia. Отчасти это правда, производитель специально затачивает серии GPU под специальные задачи, например, серия GTX отлично показывает себя в играх, а специальные вычислительные машины на основе графических процессоров Tesla используются в научных и технических исследованиях.

Однако по факту получается, что видеокарта практически не задействуется в обработке 3D-сцен, моделей и видео. Ее мощности используются преимущественно для генерации изображения в окне проекции редактора — вьюпорте. Если вы занимаетесь монтажем или моделированием, то рекомендуем прежде всего обратить внимание на мощность процессора и объем оперативной памяти.

В этой статье мы подробно рассмотрели роль видеокарты в компьютере, рассказали о ее предназначении в играх и специальных программах. Данный компонент выполняет важные действия, благодаря GPU мы получаем красивую картинку в играх и корректное отображение всей визуальной составляющей системы.

Помимо этой статьи, на сайте еще 12435 инструкций.

Добавьте сайт Lumpics.ru в закладки (CTRL+D) и мы точно еще пригодимся вам.

Отблагодарите автора, поделитесь статьей в социальных сетях.

Колонка редактора: а зачем вам мощная видеокарта?

Вот свежий пример — NVIDIA GTX TITAN. Да, на сегодняшний день, это самая мощная однопроцессорная видеокарта. Но стоимость! За неё хотят 35 тысяч рублей и даже больше! Только подумайте: лет шесть-семь назад за такие деньги собирался компьютер, близкий к топовому, на котором работали все игры на максимальных настройках. И, кстати, мало что изменилось: сегодня тоже можно за 35-40 тысяч рублей собрать хороший системный блок.

Зачастую разница между «железкой» из среднего ценового сегмента и из топового настолько мизерна, что её реально нужно выискивать. Особенно это касается процессоров. Если вы не монтируете видео и не занимаетесь тому подобными вещами, то вам придётся постараться, чтобы найти разницу в производительности между процессором за 5 и за 10 тысяч рублей. Однако производители всячески провоцируют нас покупать железо ещё и ещё дороже, приводя, как правило, не очень убедительные для меня доводы. Зачем реально нужна видеокарта уровня NVIDIA GTX TITAN? Ну, кроме понтов, конечно.

Сейчас на меня многие набросятся и вспомнят про Crysis 3, который только что вышел, но уже «поставил на колени» даже мощные компьютеры. Но подумайте, вы действительно считаете, что стоит покупать такую дорогую видеокарту только для того, чтобы с комфортом пройти ОДНУ игру?

Покупать видеокарту «на вырост» — тоже глупое занятие. Долго играть на одной карте вам не позволят неписанные правила, которые установили производители операционных систем и игр. Через пару лет выйдет новая «крутая» версия DirectX, и вы все равно не сможете выкрутить на максимум какую-нибудь одну настройку в любимой игре. Вот тут и начнётся подзуживание в том самом месте. Как так: я отвалил год-два назад столько денег за мощнейшую видеокарту, а тут на тебе — не активируется какая-то функция. И вы снова пойдёте за более современной видеокартой, даже если та, что установлена в вашу систему, будет показывать хорошую частоту кадров. Наверное, без ущерба остальному, такое возможно только в очень богатой стране.

Поэтому покупать «самый крутой топ» имеет смысл только в том случае, если для вас это совершенно безболезненная покупка и вы даже не заметите исчезновения тысячи долларов в кошельке. В противном случае, советую покупать «уверенные среднячки», которые и вытянут все, и продадутся впоследствии с минимальными потерями. Такая продуманность совершенно не понравится производителям железа, но зато очень понравится вашему кошельку.

Нужна ли видеокарта для работы

Когда нужна 3D-графика

Исторический экскурс (см. врезку) показывает, что игровые приложения становятся фактически единственным применением трехмерных ускорителей. Но ведь существует и множество других предназначений для персонального компьютера, в которых работа ведется исключительно с 2D-объектами – начиная от офисных приложений и заканчивая программами для создания собственного видео. Именно по этой причине авторы последних версий ОС Windows сделали столь явный акцент на многочисленные, но совершенно бесполезные красивости в интерфейсе пользователя (вспомним хотя бы Aero): имея в своем распоряжении мощнейший спецпроцессор, можно без проблем задействовать его ресурсы. Конечно, логичнее было бы предположить появление 3D-интерфейса, но, увы, он не прижился. Хотя попытки создать его предпринимаются и по сей день, и пользовательские фан-группы есть, впрочем, их количеством можно пренебречь: основная масса предпочитает старый добрый двумерный подход. Это касается не только интерфейсов: системы обработки изображений (графические редакторы, растровые и векторные), системы проектирования, среды программирования, верстка, дизайн, работа со звуком – все направлено исключительно на двумерную среду. И здесь помочь не могут даже самые навороченные и сложные видеоадаптеры: по сути, пользователь не заметит разницы между простейшим встроенным видео и четырехпроцессорным дискретным 3D-ускорителем. Та же история и с кодированием видео: в лучшем случае востребованным останется только интерфейс HDMI – но им уже оснащены даже материнские платы с интегрированным GPU. Единственное исключение из правила – системы создания и моделирования трехмерных объектов. В таких графредакторах, безусловно, необходимы дискретные 3D-ускорители. А кроме них остаются только игры. Всем другим приложениям современная видеокарта практически не нужна. Словом, если вы не фанат суперсовременных трехмерных игр и не работаете в системах такого же моделирования, то и видеокарта подойдет любая, в том числе встроенная. Но чтобы не быть голословным, я попробую рассмотреть ситуацию подробнее.

Для каких приложений полезно ускорение при помощи GPU

Прежде всего отметим некоторые, можно сказать, исключительные моменты. Конечно, нельзя однозначно говорить, будто для таких случаев видеокарта очень полезна, но и упускать из виду возможность немного улучшить жизнь и ускорить выполнение определенных операций не стоит.

Итак, прежде всего – графический редактор. Широко распространенный Photoshop, как и прежде, опирается на производительность CPU и HDD, но в версии CS4 появилась поддержка OpenGL, что позволило немного разгрузить центральный процессор и увеличить скорость отрисовки изображения. Для доступа к графическому процессору Photoshop необходимо, чтобы видеоакселератор располагал данной технологией, а также имел достаточно оперативной памяти (от 128 Мбайт) и драйверы, предусматривающие наличие OpenGL 2.0 и Shader Model 3.0. Проверить, как это работает на вашем компьютере, можно, проследовав по меню Edit – Preferences – Performance: если видеокарта поддерживается, опция будет доступна. Если же нет или вы только планируете приобрести видеокарту – лучше всего посетить сайт Adobe и просмотреть список совместимых устройств. А заодно и прочитать приведенный там же FAQ: для некоторых видеокарт (причем недешевых) выложен список проблем совместимости. Тем не менее в перечне проверенных видеокарт встречаются варианты любого уровня, от встроенных Intel Graphics Media Accelerator HD до NVIDIA Quadro FX 3700, что позволяет увеличить производительность Photoshop CS4 решениями любой ценовой категории. Таким образом можно получить сглаженное отображение при любом уровне масштабирования, а также анимированное масштабирование, анимированные переходы при масштабировании одним кликом, «толкание рукой» изображения, вид с высоты птичьего полета, поворот холста, гладкое отображение изображений с неквадратными пикселями, сетку для пикселей и предпросмотр кисти. Кроме того, соответствие цветов будет обрабатываться при помощи графического процессора и станут доступными различные функции для обработки 3D-изображений. К сожалению, пользователям 64-разрядной Windows XP эти возможности не доступны из-за отсутствия драйверов, а пользователям Vista потребуется активировать ее самостоятельно (по умолчанию она отключена у данной ОС).

Переложить часть нагрузки с CPU на видеопроцессор – заманчивая идея не только для графических редакторов. Современные браузеры также вынуждены отображать большое количество информации, что отнимает много ресурсов системы. А потому в 9-й версии Internet Explorer заявлена поддержка технологий Direct2D и DirectWrite, соответственно, практически все операции по обработке графики и видео выполняются видеокартой. Правда, воспользоваться этим смогут только владельцы ОС Windows Vista и 7. Ожидается, что в ближайшее время у остальных браузеров также появится аппаратное ускорение, хотя основное его применение – все те же игры и анимированные приложения.

И наконец, аппаратная поддержка кодирования видео, предоставляемая некоторыми современными моделями видеокарт (H.264/AVC), тоже призвана ускорить операции по сжатию видео. Но энтузиасты отмечают, что на практике ощутимой выгоды не наблюдается, если речь идет о создании собственных видеороликов. Если же перекодировать большое количество HD-медиаконтента для личных мобильных устройств, напротив, выигрыш присутствует, и немалый. Так, благодаря технологии Intel Quick Sync Video и встроенному графическому ядру время «перегона» видео сокращается значительно: по некотором оценкам, скорость может возрастать в 17 раз.

Следует упомянуть еще об одном важном моменте – это актуально для тех пользователей, кто хочет иметь в своем распоряжении ноутбук с мощной дискретной графикой, но не намерен терять в мобильности (то есть во времени автономной работы), – технологии nVidia Optimus. Главное ее назначение – задействовать видеокарты в зависимости от используемого приложения. Другими словами, работаем с офисным пакетом – включается интегрированная графика, снижается энергопотребеление; запускаем игру или другое ресурсоемкое приложение – система автоматически активирует более мощную дискретную, растет производительность. По примерным подсчетам благодаря такому подходу удается продлить время работы от батарей от 1,5 до 2,5 раза, но точнее сказать трудно: слишком причудливо система выбирает, когда и какую видеокарту использовать.

Какие нетрадиционные применения GPU существуют

Факт остается фактом: на борту современной видеокарты установлен очень мощный компьютер. Самостоятельный, со своим ПО, процессорами, памятью, и прочими атрибутами. Что и послужило

На бумаге все красиво, но вот в реальной жизни. Попытка использовать такую технологию сразу же продемонстрировала ее слабые места. Прежде всего, переносимость – об этом речь вообще не идет, что резко ограничивает возможности распространения готового решения. Закрытая архитектура также накладывает негативный отпечаток, но это все можно было бы списать на несовершенство и «юный возраст» технологии, если бы не другие моменты. Так, некоторые исследователи жалуются на отсутствие обработчика критических ошибок – при их возникновении компьютер просто зависает. Есть трудности и с функционированием ОС в связке с драйвером: не получая от него отклика, операционная система попросту посылает команду сброса каждые 5–10 секунд, делая невозможной работу программы свыше указанного времени. Конечно, с проблемами пытаются бороться, но после прочтения очередного отзыва от экспериментаторов становится понятно, что сейчас это не более чем игрушка для энтузиастов, практическое применение которой будет найдено не скоро. Если, разумеется, будет найдено вообще.

Выводы напрашиваются сами собой: для большинства пользовательских приложений возможностей самой простой современной встроенной графики хватит с лихвой. Просмотр видео, обработка и редактирование фотографий, оцифровка и монтаж видео, работа с мультимедиаконтентом, а также практически все без исключения современные приложения требуют для своей работы только 2D-ускорителя. Что бы ни рассказывали маркетологи, какими бы супертехнологиями ни оперировали – в большинстве случаев все это останется невостребованным в реальной жизни. Исключения, как уже говорилось, делаются только для игр и редакторов трехмерной графики – именно для них нужны хорошие, качественные и недешевые ускорители.

Что же касается игровых приложений, здесь варианты выбора упростились до минимума – достаточно прочесть рекомендации разработчика игры или приобрести самый дорогой адаптер (из доступных по бюджету). Впрочем, если вы заядлый геймер, то и без подсказок знаете, что делать!

Что представляет собой современная видеокарта?

С этого вопроса придется начать, потому что многие пользователи совершенно не представляют истинного положения вещей и предполагают, будто это устройство для подключения монитора. А ведь еще относительно недавно это было не одно, а несколько устройств, и предназначались они для разных задач.

Итак, небольшой экскурс в историю. Давным-давно, когда компьютеры были восьмибитными, такого понятия, как «видеокарта» не существовало вовсе. И тем не менее, многие из нас прекрасно помнят и «Денди», и SEGA, и ATARI, и ZX-SPECTRUM, имевших графику, в том числе игры, весьма приличного качества. Достигалось это специфической схемотехникой, уникальной для каждого случая, но в подробности вдаваться не стану, упомяну лишь, что схема, отвечающая за формирование видеосигнала, являлась неотъемлемой частью компьютера и была задействована в других узлах. Например, тот же ZX-SPECTRUM при чтении файла с магнитофонной ленты создавал специфическое изображение на части экрана – бордюре. По сути, главная роль видеомодуля сводилась к преобразованию цифрового изображения в растровое, пригодное для отображения на дисплее или телевизоре, который пришел на смену печатающему устройству – АЦПУ.

Отдельным узлом видеоадаптер стал, пожалуй, только в IBM-совместимых ПК. Один из первых, CGA, позволял формировать растровое изображение (320×200 пикселей, 16 цветов; 640×200 пикселей, 2 цвета), не делая при этом никаких самостоятельных вычислений: подготовка и формирование картинки выполнялась только центральным процессором. По этому же принципу изготовлялись и другие модели, благодаря чему выводимое изображение было исключительно двумерным.

Ситуация кардинально изменилась только с изобретением 2D-акселлераторов и появлением у видеокарт собственного процессора (GPU) – он существенно разгрузил CPU и уменьшил количество данных, передаваемых между центральным процессором и видеомодулем. Теперь такие операции, как построение линии по двум точкам, рисование геометрических фигур и примитивов, которые были занесены в GDI (графический интерфейс Windows), стали делом графического процессора. Ускорение достигалось еще и тем, что GPU был неизмеримо лучше приспособлен для подобных операций и выполнял их быстрее, чем CPU. 2D-акселератор взял на себя прорисовку отдельных элементов – например, рабочего столал, окон приложений, курсора и т. д.

высокопроизводительные 2D-ускорители для профессиональных инженерных применений.

Перелом наступил в середине 1990-х, с появлением 3D-акселераторов, ориентированных на ускорение вывода трехмерной графики. Точнее говоря, это произошло летом 1996 год, когда начался выпуск трехмерных игр (конкретно Quake), в которых был реализован полностью полигональный трехмерный мир – с его отрисовкой классические видеокарты уже не справлялись. Примечательно, что отдельные компании, сконцентрировавшие усилия на разработке видеокарт, проигнорировали данное направление, предпочитая совершенствовать двухмерные акселераторы: по их мнению, «игрушками» заниматься несолидно, а персональные компьютеры достойны гораздо лучшего применения, чем в качестве игровой приставки. Увы, история показала, что таким подходом они подписали себе смертный приговор – пользователи рассудили иначе и теперь уже пятое поколение графических карт представляет собой высокопроизводительные 3D-ускорители.