Работу с данными нужно начинать с чего

Цикл работы с данными

Digital-Content-Files.jpg Цикл работы с данными этапы и виды работ, которые необходимо проделать, чтобы получить новую информацию на их основе 200 Данные и их применение Начальная Полезно IT/soft Да Данные (раздел) Цифровая экономика (раздел) Базовые понятия (раздел) Межотраслевое (раздел) Базовые информационные технологии (раздел) Системы баз данных (раздел) 4 Цикл работы с данными

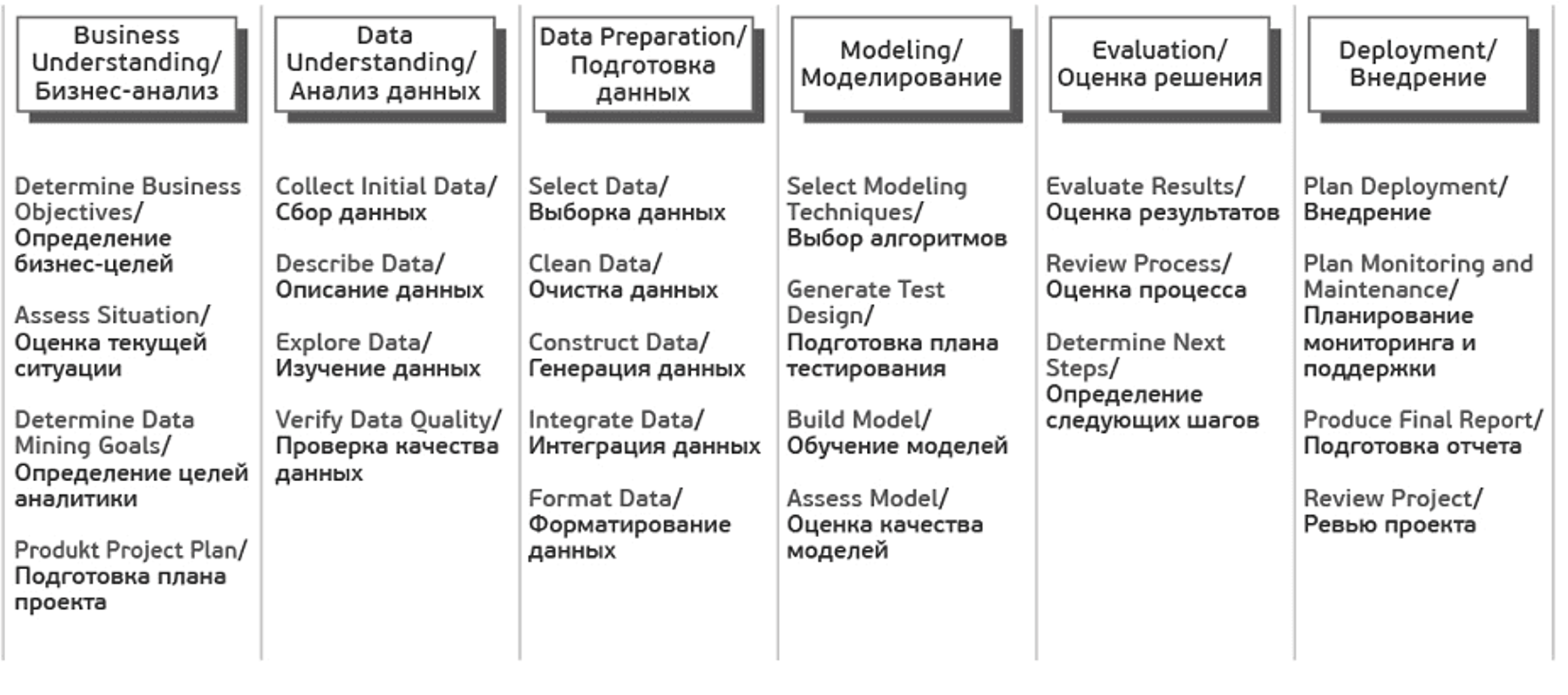

Один из подходов работы с данными – это методология исследования данных CRISP, которая включает в себя шесть этапов: понимание бизнеса, начальное изучение данных, подготовка данных, моделирование, оценка решения и внедрение.

Цикл работы с данными по методологии CRISP

CRISP-DM (Cross-Industry Standard Process for Data Mining — межотраслевой стандартный процесс для исследования данных) — это проверенная в промышленности и наиболее распространённая методология по исследованию данных.

Данная схема включает в себя шесть этапов

Понимание бизнеса (Business Understanding) – на первом этапе работы с данными вам нужно понять, зачем вам собирать и анализировать данные, а также какие данные вам необходимы. Определение целей и предварительные гипотезы на данных затем лягут в основу вашего проекта.

Задачи фазы Business Understanding:

Начальное изучение данных (Data Understanding) – на втором этапе работы с данными вам нужно оценить качество ваших данных: насколько данные полные, есть ли в них ошибки, пробелы и пропуски. Нужно понять, какими сведениями вы обладаете, сформулировать к ним вопросы и итоговые гипотезы о скрытых закономерностях

Задачи фазы Data Understanding:

Подготовка данных (Data Preparation) – на этом этапе вам нужно сформировать итоговый набор данных для анализа, “очистить” данные, привести их в единых формат из исходных разнородных и разноформатных данных.

Задачи фазы Data Preparation могут выполняться много раз без какого-то заранее определенного порядка:

Моделирование (Modeling) – на этом этапе вам нужно выбрать методику, каким образом анализировать данные, построить модель анализа. Модель должна отражать весь их процесс анализа (что вы хотите выяснить с помощью анализа данных, какие данные вы используете, как они организованы, как они обработаны, и так далее). У вас может возникнуть необходимость вернуться к фазе подготовки данных, так как разные методы анализа требуют различных форматов данных. Задачи фазы Modeling:

Оценка (Evaluation) – определение, удалось ли достигнуть целей с помощью разработанной модели и полученных результатов анализа. Данный этап позволяет понять, действительно ли те шаги, которые вы запланировали, позволяют получить те результаты, которые вы хотели. На данном этапе могут быть выявлены более важные задачи организации, которые не были учтены. Задачи фазы Evaluation:

Рассмотрим подробнее некоторые аспекты этапов подготовки и моделирования данных, инструменты подготовки данных и способы их моделирования

Выбор способа хранения данных зависит от объема данных, необходимой скорости доступа к ней, частоте обновлений данных, количества лиц, которым будет разрешен доступ к данным, стоимости хранения нужного объема данных.

Основной формой хранения данных является база данных. С помощью СУБД можно получить доступ к данным, записать их, переместить, изменить, удалить.

В зависимости от выбранной модели, решаемой задачи подбираются технологии, тип базы данных, которые будут наиболее эффективны в конкретном случае. К процедурам обработки данных относятся: создание данных, модификация данных, поиск информации, принятие решений, создание отчетов, создание документов, повышение безопасности данных.

При обработке данных обращают внимание на их качество. Выделяют чистые и грязные данные. Грязные данные отличает наличие обработки, дополнительной, не связанных с первоначальными данными, информации, недостаток первичных данных. Все это мешает полному анализу данных, так как грязные данные уже содержат в себе некоторые критерии анализа, “обнулить” значение которых нельзя.

В связи с объемом анализируемых данных визуализация – это необходимый способ оформления данных в понятный человеку вид. Поэтому инструменты визуализации важны в работе с данными.

Вид визуализации данных:

Работа с данными: возможности и примеры

Телеком, ритейл, банки, ОФД, wi-fi операторы и кассы знают о покупателях очень много и могут обогатить собственные данные компаний. Однако прежде чем обращаться к дата-поставщикам, следует изучить возможности собственных данных. Для тех, кто пока не собирает свои данные, Яна Саулова, руководитель отдела аналитики, «Риалвеб», и Катя Жукова, руководитель направления развития стратегических партнёрств, «Риалвеб», расскажут о возможностях решений таких задач с помощью CRM, DMP и CDP. Если у вас уже есть накопленный пласт данных, главная задача — собрать из него максимум информации.

Последние несколько лет одним из самых популярных трендов в digital выступает О2О-маркетинг. На тему того, как объединить онлайн и офлайн данные, а также замерить эффективность омниканальных кампаний сейчас активно публикуются статьи и ведутся открытые обсуждения кейсов.

К 2021 году сложилась экосистема поставщиков данных, которые легально помогают брендам запускать персонализированные рекламные кампании. Такие запуски сопровождаются исследованиями, в которые могут быть включены: верификация сегментов, измерение эффекта кампании на продажи, составление подробного портрета покупателей продукта.

В первую очередь обращаться к поставщикам данных начали крупные международные бренды, сейчас региональные компании также осваивают новые каналы. На данный момент динамика сохраняется, и работа с поставщиками должна стать обыденностью, а не экспериментом в формате теста с минимальным бюджетом.

Агрегировать 3-d party данные из различных систем мы начали в конце 2019 года. У нас было несколько успешных кейсов, когда стало понятно, что из агрегированных данных можно получить действительно значимые инсайты и главное, появляются конкурентоспособные идеи по оптимизации рекламных размещений.

Инсайты — это те выводы, которые мы получаем, агрегировав данные и углубившись в их анализ, то есть это выводы, которые не лежат на поверхности. По факту — это данные, которые помогают лучше понимать целевую аудиторию, их мотивы и потребности.

Аналитик также играет ключевую роль при работе с данными, потому что он способен собрать все цепочки пользовательских паттернов в единую структуру и уже по не разрозненным данным восстановить закономерности в паттернах поведения аудитории.

Как правило, мы чаще работаем с кастомизированными собственными решениями, чем с готовыми решениями, которые уже много лет существуют на рынке. Мы работаем с разными клиентами и с различными данными, поэтому нам важно оставаться гибкими, встраивая собственные идеи и гипотезы на разных уровнях в течение всего цикла ведения клиента в агентстве — от запуска до получения первых репрезентативных данных.

Перед нами была поставлена задача клиентом из сферы фармацевтики по поиску пользователей в социальных сетях, которые упоминали в комментариях о различных симптомах — нас интересовали пользователи, которые в группах конкурентов обсуждали головную боль, насморк, снижение иммунитета и тд. Таким образом, мы собрали обезличенные данные пользователей с сопутствующей симптоматикой для последующего анализа данных, что позволило нам глубже изучить аудиторию и ее потребности.

Например, мы смогли охарактеризовать потенциальную аудиторию с точки зрения половозрастной структуры и интересов этой аудитории.

Проанализировав большой объем данных, нам стало понятно, на какие препараты и на какую симптоматику делают акцент те или иные сегменты аудитории. Также у нас появилась возможность глубже изучить интересы аудитории конкретного бренда по тем комментариям, которые они оставляли в смежных группах социальной сети.

Нам важно оценивать влияние рекламы на решение пользователей о покупке. Но как оценить влияние рекламы в случае, если пользователь видел рекламу, но не кликнул в моменте, а после перешел на сайт с другого источника? В этом случае нам на помощь приходят данные из CRM клиента. Такой кейс у нас был с одной крупной компанией-застройщиком. Перед нами были поставлены следующие задачи:

Для решения этих задач нам потребовалось агрегировать данные об онлайн активности пользователей с данными из CRM-клиента. В качестве уникального идентификатора для объединения данных по онлайн и офлайн активности мы взяли Client ID пользователя. Потом мы сопоставили тех пользователей, которые были на сайте до сделки, с теми покупателями, которые совершили сделку в офлайне. Для этого мы вернули в онлайн аудиторию, совершившую сделку с помощью email-рассылки.

После такой интеграции мы смогли ответить на вопросы:

В первую очередь, мы рекомендуем использовать данные из всех доступных источников для увеличения шансов получить инсайты о своей аудитории, и уже после этого обращаться к внешним сторонним поставщикам.

С помощью агрегации различных данных у нас появляется возможность глубокого изучения аудиторных данных для дальнейшего использования этих данных при оптимизации рекламных размещений. Мы видим, что работать с данными из различных систем выгодно.

Big Data от А до Я. Часть 1: Принципы работы с большими данными, парадигма MapReduce

Привет, Хабр! Этой статьёй я открываю цикл материалов, посвящённых работе с большими данными. Зачем? Хочется сохранить накопленный опыт, свой и команды, так скажем, в энциклопедическом формате – наверняка кому-то он будет полезен.

Проблематику больших данных постараемся описывать с разных сторон: основные принципы работы с данными, инструменты, примеры решения практических задач. Отдельное внимание окажем теме машинного обучения.

Начинать надо от простого к сложному, поэтому первая статья – о принципах работы с большими данными и парадигме MapReduce.

История вопроса и определение термина

Термин Big Data появился сравнительно недавно. Google Trends показывает начало активного роста употребления словосочетания начиная с 2011 года (ссылка):

При этом уже сейчас термин не использует только ленивый. Особенно часто не по делу термин используют маркетологи. Так что же такое Big Data на самом деле? Раз уж я решил системно изложить и осветить вопрос – необходимо определиться с понятием.

В своей практике я встречался с разными определениями:

· Big Data – это когда данных больше, чем 100Гб (500Гб, 1ТБ, кому что нравится)

· Big Data – это такие данные, которые невозможно обрабатывать в Excel

· Big Data – это такие данные, которые невозможно обработать на одном компьютере

· Вig Data – это вообще любые данные.

· Big Data не существует, ее придумали маркетологи.

В этом цикле статей я буду придерживаться определения с wikipedia:

Большие данные (англ. big data) — серия подходов, инструментов и методов обработки структурированных и неструктурированных данных огромных объёмов и значительного многообразия для получения воспринимаемых человеком результатов, эффективных в условиях непрерывного прироста, распределения по многочисленным узлам вычислительной сети, сформировавшихся в конце 2000-х годов, альтернативных традиционным системам управления базами данных и решениям класса Business Intelligence.

Таким образом под Big Data я буду понимать не какой-то конкретный объём данных и даже не сами данные, а методы их обработки, которые позволяют распредёлено обрабатывать информацию. Эти методы можно применить как к огромным массивам данных (таким как содержание всех страниц в интернете), так и к маленьким (таким как содержимое этой статьи).

Приведу несколько примеров того, что может быть источником данных, для которых необходимы методы работы с большими данными:

· Логи поведения пользователей в интернете

· GPS-сигналы от автомобилей для транспортной компании

· Данные, снимаемые с датчиков в большом адронном коллайдере

· Оцифрованные книги в Российской Государственной Библиотеке

· Информация о транзакциях всех клиентов банка

· Информация о всех покупках в крупной ритейл сети и т.д.

Количество источников данных стремительно растёт, а значит технологии их обработки становятся всё более востребованными.

Принципы работы с большими данными

Исходя из определения Big Data, можно сформулировать основные принципы работы с такими данными:

1. Горизонтальная масштабируемость. Поскольку данных может быть сколь угодно много – любая система, которая подразумевает обработку больших данных, должна быть расширяемой. В 2 раза вырос объём данных – в 2 раза увеличили количество железа в кластере и всё продолжило работать.

2. Отказоустойчивость. Принцип горизонтальной масштабируемости подразумевает, что машин в кластере может быть много. Например, Hadoop-кластер Yahoo имеет более 42000 машин (по этой ссылке можно посмотреть размеры кластера в разных организациях). Это означает, что часть этих машин будет гарантированно выходить из строя. Методы работы с большими данными должны учитывать возможность таких сбоев и переживать их без каких-либо значимых последствий.

3. Локальность данных. В больших распределённых системах данные распределены по большому количеству машин. Если данные физически находятся на одном сервере, а обрабатываются на другом – расходы на передачу данных могут превысить расходы на саму обработку. Поэтому одним из важнейших принципов проектирования BigData-решений является принцип локальности данных – по возможности обрабатываем данные на той же машине, на которой их храним.

Все современные средства работы с большими данными так или иначе следуют этим трём принципам. Для того, чтобы им следовать – необходимо придумывать какие-то методы, способы и парадигмы разработки средств разработки данных. Один из самых классических методов я разберу в сегодняшней статье.

MapReduce

Про MapReduce на хабре уже писали (раз, два, три), но раз уж цикл статей претендует на системное изложение вопросов Big Data – без MapReduce в первой статье не обойтись J

MapReduce – это модель распределенной обработки данных, предложенная компанией Google для обработки больших объёмов данных на компьютерных кластерах. MapReduce неплохо иллюстрируется следующей картинкой (взято по ссылке):

MapReduce предполагает, что данные организованы в виде некоторых записей. Обработка данных происходит в 3 стадии:

1. Стадия Map. На этой стадии данные предобрабатываются при помощи функции map(), которую определяет пользователь. Работа этой стадии заключается в предобработке и фильтрации данных. Работа очень похожа на операцию map в функциональных языках программирования – пользовательская функция применяется к каждой входной записи.

Функция map() примененная к одной входной записи и выдаёт множество пар ключ-значение. Множество – т.е. может выдать только одну запись, может не выдать ничего, а может выдать несколько пар ключ-значение. Что будет находится в ключе и в значении – решать пользователю, но ключ – очень важная вещь, так как данные с одним ключом в будущем попадут в один экземпляр функции reduce.

2. Стадия Shuffle. Проходит незаметно для пользователя. В этой стадии вывод функции map «разбирается по корзинам» – каждая корзина соответствует одному ключу вывода стадии map. В дальнейшем эти корзины послужат входом для reduce.

3. Стадия Reduce. Каждая «корзина» со значениями, сформированная на стадии shuffle, попадает на вход функции reduce().

Функция reduce задаётся пользователем и вычисляет финальный результат для отдельной «корзины». Множество всех значений, возвращённых функцией reduce(), является финальным результатом MapReduce-задачи.

Несколько дополнительных фактов про MapReduce:

1) Все запуски функции map работают независимо и могут работать параллельно, в том числе на разных машинах кластера.

2) Все запуски функции reduce работают независимо и могут работать параллельно, в том числе на разных машинах кластера.

3) Shuffle внутри себя представляет параллельную сортировку, поэтому также может работать на разных машинах кластера. Пункты 1-3 позволяют выполнить принцип горизонтальной масштабируемости.

4) Функция map, как правило, применяется на той же машине, на которой хранятся данные – это позволяет снизить передачу данных по сети (принцип локальности данных).

5) MapReduce – это всегда полное сканирование данных, никаких индексов нет. Это означает, что MapReduce плохо применим, когда ответ требуется очень быстро.

Примеры задач, эффективно решаемых при помощи MapReduce

Word Count

Начнём с классической задачи – Word Count. Задача формулируется следующим образом: имеется большой корпус документов. Задача – для каждого слова, хотя бы один раз встречающегося в корпусе, посчитать суммарное количество раз, которое оно встретилось в корпусе.

Раз имеем большой корпус документов – пусть один документ будет одной входной записью для MapRreduce–задачи. В MapReduce мы можем только задавать пользовательские функции, что мы и сделаем (будем использовать python-like псевдокод):

Функция map превращает входной документ в набор пар (слово, 1), shuffle прозрачно для нас превращает это в пары (слово, [1,1,1,1,1,1]), reduce суммирует эти единички, возвращая финальный ответ для слова.

Обработка логов рекламной системы

Второй пример взят из реальной практики Data-Centric Alliance.

Задача: имеется csv-лог рекламной системы вида:

Необходимо рассчитать среднюю стоимость показа рекламы по городам России.

Функция map проверяет, нужна ли нам данная запись – и если нужна, оставляет только нужную информацию (город и размер платежа). Функция reduce вычисляет финальный ответ по городу, имея список всех платежей в этом городе.

Резюме

В статье мы рассмотрели несколько вводных моментов про большие данные:

· Что такое Big Data и откуда берётся;

· Каким основным принципам следуют все средства и парадигмы работы с большими данными;

· Рассмотрели парадигму MapReduce и разобрали несколько задач, в которой она может быть применена.

Первая статья была больше теоретической, во второй статье мы перейдем к практике, рассмотрим Hadoop – одну из самых известных технологий для работы с большими данными и покажем, как запускать MapReduce-задачи на Hadoop.

В последующих статьях цикла мы рассмотрим более сложные задачи, решаемые при помощи MapReduce, расскажем об ограничениях MapReduce и о том, какими инструментами и техниками можно обходить эти ограничения.

Спасибо за внимание, готовы ответить на ваши вопросы.

«А поговорить?»: с чего начать работу с данными

Теории и практики

Допустим, вы — компания, накопившая множество потенциально полезных данных (ту самую «бигдату»). Можно обратиться к аналитику, чтобы он вытащил из них какой-нибудь полезный для бизнеса инсайт. Но вы ошибаетесь, если думаете, что для этого достаточно прогнать весь массив через волшебный алгоритм. Хороший аналитик сначала замучает вас вопросами о том, чего вы хотите (а вы поймете, что сами не знаете) и зачем (а вы поймете, что, может, и незачем). А если вы и есть тот самый аналитик, читайте о том, с чего начать работу с данными, в отрывке из книги Кирилла Еременко, предпринимателя и генерального директора образовательного онлайн-портала для аналитиков данных SuperDataScience.

Работа с данными в любой сфере: Как выйти на новый уровень, используя аналитику

Кирилл Еременко

Альпина Паблишер. 2019

Смотри, мама, никаких данных!

Несмотря на всю важность, выявление проблемы, как правило, является наиболее часто игнорируемой частью проектов, использующих данные. Я и сам грешил этим, поскольку долгое время начинал проекты с подготовки данных. Но это было не потому, что хотел проскочить вперед; я просто думал, что постановки проблемы достаточно. В конце концов, аналитики данных часто привлекаются к работе над проблемами, и на моей первой работе в Deloitte все проекты начинались с технического задания, в котором уточнялось то, что от меня требуется, и указывалось, где нужна помощь. Неудивительно, что фирма стандартизировала и упорядочила процесс, но это только сформировало во мне плохую привычку бежать впереди паровоза, прежде чем представить себе целостную картину.

Еще одна причина пренебрежения определением вопроса заключается в том, что на этом этапе не используется много данных (если они вообще используются), в результате чего многие аналитики данных относятся немного снисходительно к выполнению этого этапа. Но важно отметить, что те, кто предложил вопрос, вероятно, не являются специалистами по данным и не знают о подготовке, необходимой для очистки и анализа данных. Немногие компании на сегодняшний день информируют своих сотрудников о важности хранения информации и обеспечения доступа к ней, и этот пробел в знаниях означает, что

у многих аналитиков данных все еще спрашивают: «У нас есть много данных, может быть, вы сформулируете какие-то идеи на их основе?»

Подобные вопросы задаются очень часто, хотя они туманны, расплывчаты и ничему не способствуют в процессе решения проблемы компании*.

Таким образом, даже если вопрос был сформулирован заранее и ваш босс спрашивает, почему вы не занимаетесь обработкой данных, не думайте о себе как о сумасброде. Изложите свои доводы. Просто предложить вопрос недостаточно — он должен быть переформулирован в терминах, которые будут соответствовать имеющимся данным, иначе реализация проекта застопорится.

Как решить такую проблему, как…

Задания, которые поступают от руководства организации или от инвесторов, часто постулируются как открытые пути к вопросу, а не реальный вопрос как таковой: «Мы недопоставляем единицы продукции», или «Наши клиенты покидают нас быстрее, чем ожидалось», или «В нашем продукте есть дефект». Ни одно из этих утверждений не является вопросом. Я призываю читателей применять следующий поэтапный подход к выявлению и решению проблемы на основе данных. Это сделает первый этап более эффективным и снизит риск того, что вы сосредоточитесь на неправильной проблеме.

1. Поймите проблему

Любой, кто планирует участвовать в проектах, связанных с данными, должен прежде всего знать о ловушке, в которую он может невольно попасть еще до того, как работа начнется: если последовать решению коллеги относительно того, какими вопросами следует заняться, можно фактически выбрать ошибочную проблему. Коллега может иметь благие намерения и пытаться быть более полезным, представляя разработанные им вопросы, но они необязательно будут пригодны для запроса, адресованного данным. Заманчиво, получив несколько, по-видимому, хорошо сформулированных запросов, не беспокоиться о том, чтобы идентифицировать вопрос самостоятельно. Но это может привести к катастрофе в дальнейшем процессе; именно от вас зависит определение всех параметров бизнес-проблемы, потому что вы обучены тому, как это сделать. Слепое заимствование набора вопросов у специалиста, не связанного с данными, и применение их к вашему проекту может увенчаться решением не той проблемы или просто не привести к результатам, потому что у вас нет для них необходимых данных.

Прежде чем начать непосредственно трудиться над проектом, в первую очередь нужно поговорить с человеком, который поставил перед нами проблему. Понимание не только того, что это за проблема, но и почему она должна быть решена сейчас, кто основные заинтересованные стороны и что ее решение будет означать для учреждения, поможет начать «отладку» нашего исследования. Без этого шага результат может оказаться опасным для аналитика данных, так как в дальнейшем по ходу проекта мы, несомненно, интерпретируем поставленный вопрос иначе, чем заинтересованные стороны. Как только мы разобрались с центральной проблемой, можно перейти ко второму шагу.

2. Изучить отрасль

Если у вас уже имеются знания о сфере, в которой вас просят работать, это отличное начало. Вы можете применить свой опыт. Вы, возможно, уже знаете, например, конкретные проблемы, с которыми обычно сталкиваются компании, работающие в этом секторе, или можете быть в курсе того, какие отделы, как правило, занимались этими вопросами успешно или тщетно либо какие конкурирующие компании обнаружили и решили именно те проблемы, которые были поставлены перед вами. Если у вас нет знаний об отрасли, не все потеряно. Потратьте некоторое время, исследуя ее более подробно. Каковы подводные камни в отрасли? Столкнулись ли конкуренты вашей компании с аналогичными проблемами или же есть существенные различия? Как они решали подобные проблемы? Миссия и цели компании, для которой вы работаете, существенны для отрасли как таковой? Чем эта компания отличается от других по объему производства, организационной структуре и рабочему процессу?

Google может быть вашим лучшим другом в поиске ответа на многие из этих вопросов, но также помните, что

как аналитик данных вы не работаете в вакууме. Детальное знание среды, где вы действуете, а также ее индивидуальных особенностей и ограничений поможет вам разработать подход, значимый для тех, кто так или иначе связан с проектом.

Не будьте отшельником. Если у вас пробелы в знаниях, используйте свой лучший ресурс — коллег. И даже если у вас есть вся необходимая информация, все равно пойдите и поговорите о том, что вы узнали, с соответствующими сотрудниками. Люди, которые вызвали ваш проект к жизни, всегда будут хорошей отправной точкой, чтобы убедиться, что вы говорите с теми, с кем нужно. Они не только помогут вам узнать недостающие сведения, но и направят к должностным лицам, ответственным за те участки в организации, где возникла проблема.

3. Думайте как консультант

Большинство согласится с тем, что наука о данных требует подхода «снизу вверх»: мы используем данные компании для проведения анализа и постепенно выстраиваем на них наши результаты, чтобы лучше понять внутренние проблемы компании. Этот потенциал данных и является тем, что делает первый шаг настолько захватывающим. Но для того, чтобы выявить вопрос, нужно обращать больше внимания на методы бизнес-консалтинга.

В консалтинге мы выделяем возможные стратегические подходы для бизнеса. В качестве консультантов, как правило, выступают люди, проработавшие в бизнесе или отрасли несколько лет и накопившие много знаний о соответствующем секторе. Они часто занимаются улучшением крупномасштабных стратегических и организационных аспектов компании, что требует нисходящего подхода, — и такая методология анализа общей картины обязывает делать определенные предположения о поставленной проблеме.

Для нас может показаться контрпродуктивным использовать консалтинговые методы; как аналитикам данных нам советуют стараться воздерживаться от предположений и использовать как можно больше достоверных данных. Но пример консультантов может быть чрезвычайно полезен, особенно на первом этапе процесса. Итак, забудьте на мгновение о своих технических знаниях и

посмотрите на организацию, участников проекта и стратегию компании, прежде чем начать размышлять о данных.

В конце концов, определение вопроса касается фильтрации имеющихся вариантов, и этот третий шаг поможет уточнить вопросы, чтобы они стали соответствовать потребностям нашей компании.

Составьте список ключевых участников проекта и особо отметьте, кто будет принимать окончательное решение. Проведите с ними некоторое время и не переходите к четвертому шагу, пока не сможете ответить на следующие вопросы:

Что каждый из участников проекта думает о проблеме?

Каковы грани этой проблемы?

Какие отделы должны быть в фокусе моего внимания?

В чем могут быть первопричины проблемы?

Считают ли участники, что я должен поговорить с еще? Я с ними разговаривал?

Где находятся данные и кто за них отвечает?

Что будет означать успех этого проекта?

4. Осознайте ограничения

Что делать, если после всей проделанной здесь работы мы обнаружим, что данных, которые мы расценили как необходимые для нашего исследования, нет?

Наиболее эффективный подход заключается в том, чтобы изучить высший уровень массива данных и понять, какие данные у нас на самом деле есть и необходим ли дополнительный сбор сведений, прежде чем проект сможет двигаться вперед. Опять же, это означает общение с правильными людьми — теми, кто отвечает за существующие данные компании. Благодаря такому общению мы сможем получить более полное представление о том, где в данных могут обнаружиться проблемы и где нам может понадобиться дополнительная информация, чтобы гарантировать статистическую значимость выбранных нами данных. Этот шаг немного напоминает дилемму курицы и яйца, ведь

мы должны знать, какие вопросы задать данным, прежде чем мы увидим эти базы данных.

Но мы также должны убедиться в том, что уже на ранней стадии имеем нужные данные, — иначе потеряем много времени, прежде чем приступим к следующему этапу процесса анализа данных.

Практика — лучший путь к освоению этого. Вспомните свои мысли о том, какие типы данных будут полезны для ответа на ваши вопросы. Напишите их рядом с вопросами и делайте отметки, чтобы понять, что вам нужно в каждой контрольной точке. На первом проекте это может напомнить одновременное жонглирование многими тарелками, но с опытом все станет намного проще.

Если вы работаете в компании, которая с течением времени накопила много данных, первоначальное выявление проблемы становится еще более важным делом. Я часто обнаруживал, что, хотя коллеги могут положительно воспринимать идею использования данных, они не вполне уверены, что данные могут им помочь. Это может относиться даже к людям, управляющим базами данных. И именно здесь многие компании делают неверный шаг.

По иронии судьбы из-за того, что так велико количество данных, имеющихся в распоряжении у компаний, последние перестают осознавать смысл и значение данных и, следовательно, преуменьшают их ценность.

Мы должны помочь им понять важность данных, и это путешествие начинается здесь.

5. Проведите майнинг данных (по желанию)

Глубинный анализ (майнинг) данных — возможно, самая приятная для меня часть процесса в любом проекте. То, что ученым не дают заниматься майнингом данных, немного похоже на запрет кураторам музеев изучать материалы, за которые они несут ответственность. Именно на этом этапе вы можете позволить себе быть исследователем. Для меня глубинный анализ данных — процесс, в котором вы выполняете тестирование с целью тщательного изучения данных на высшем уровне и находите области, которые могут предложить интересные идеи для дальнейшего исследования. На этом экспериментальном этапе мне нравится помещать данные в Tableau**, которое умеет их читать и поможет вам создать предварительные наглядные визуализации, такие как легко читаемые таблицы, диаграммы и графики. Это обеспечивает прекрасный задел, который вы можете использовать в качестве фокусирующей линзы, чтобы сформулировать нужные вопросы.

В конечном счете, если майнинг данных выполняется на начальном этапе проекта, он наиболее эффективно помогает лучше понять проблему и управлять процессом анализа. Это тест-драйв ваших данных: вы испытываете их в необработанном виде, чтобы увидеть, могут ли какие-либо тенденции проявиться даже на раннем этапе. Майнинг данных может сэкономить много усилий в дальнейшем. В то же время не унывайте, если он ни к чему не приведет. Данные могут предлагать или не предлагать нам дальнейшие действия или решения в зависимости от нескольких факторов, таких как компания, качество данных и уровень сложности проблемы. Итак, сделайте этот шаг, но не забывайте «делить на десять». И если вы найдете что-то интересное, запишите и убедитесь, что вы помните о своих находках, когда перейдете к шестому шагу…

6. Уточните проблему

Теперь, когда мы поняли масштаб проблемы и определили количество данных, имеющихся в нашем распоряжении, можно начать копать немного глубже. Здесь мы начинаем сопоставлять масштаб проекта с данными, чтобы отделить переменные и данные, которые будут полезны, от тех, которые не пригодятся, и чтобы надлежащим образом переформулировать вопрос.

Хотя все данные потенциально могут оказаться полезными, мы не можем использовать всю имеющуюся информацию по каждой проблеме, и это только к лучшему:

если бы все данные были полезны всегда, объем получаемой на выходе информации был бы просто слишком громоздким для управления. По этой причине мы можем быть разборчивыми по отношению к предоставленным данным. Это означает, что мы должны учесть параметры и контекст проблемы, которую хотим решить, прежде чем двигаться вперед. В конечном счете уточнение проблемы экономит время, устраняя данные, которые не имеют отношения к нашему вопросу.

7. Соберите дополнительные данные

На этом этапе вы уже определили, какие данные вам нужны, и составили разумный перечень вопросов для решения проблемы. Сейчас самое время оценить эффективность ваших подвопросов. В конце концов, просто не стоит отвечать на те вопросы, которые, как вы поняли, компанию не заинтересуют или по которым ничего не будет предпринято. Спросите себя сейчас: каковы ожидаемые результаты от этих подвопросов? Помогают ли они решить проблему или чего-то еще не хватает?

Именно здесь вы поблагодарите себя за то, что прошли предыдущие шесть шагов, достигнув этой точки; выделение ключевых областей, из которых вам нужны дополнительные данные, оптимизирует и, следовательно, ускорит процесс сбора данных. Составьте план, а затем отложите его в сторону; воздержитесь от сбора каких-либо данных вообще, пока вы не выполните восьмой шаг.

8. Проинформируйте заинтересованные стороны***

После того как мы приняли во внимание все предыдущие семь шагов, крайне необходимо, чтобы у нас, нашей команды и всех участников проекта было общее понимание ситуации. Четкая и ясная постановка проблемы, которую вы будете решать, обеспечит точный выбор подхода, и это уменьшит шансы других изменить ориентиры в процессе реализации проекта.

Сторона, обратившаяся с просьбой о выполнении проекта, должна согласиться с вашим планом решения проблемы, который в идеале должен включать в себя не только то, что касается содержания проекта, но и его временные рамки. Я настоятельно рекомендую разделить проект на этапы, что позволит всем вовлеченным лицам оставаться в курсе вашего продвижения вперед и защитит вас от любой негативной реакции в конце проекта и упреков в том, что вы скрывали свои намерения.

Также необходимо объяснить заинтересованным сторонам, что это не обычный бизнес-проект, что проекты в области науки о данных не всегда соответствуют моделям PRINCE2, которые столь знакомы и любимы бизнесом. Это поможет защитить вас от предвзятого вмешательства и даст возможность точно объяснить участникам, какие шаги вы собираетесь предпринять для выполнения задачи.

Соблюдение графика

Этот этап процесса анализа данных не должен продолжаться чересчур долго в цикле проекта. Иногда новички могут потратить на него слишком много времени, потому что хотят убедиться, что они разработали надежную методологию. Помните: вы никогда не сможете прояснить проблему до такой степени, чтобы точно знать, чего хотите. Если вы проделали хорошую работу на этом этапе, то, скорее всего, сэкономите время, но вы также должны научиться позволять процессу идти своим чередом — это умение приходит с опытом.

Если вы будете последовательно выполнять шаги, описанные выше, это застрахует вас от дальнейших трудностей и поможет обрести уверенность для перехода к своевременной подготовке данных. В конечном счете, если задача, которую перед вами поставили, не является дьявольски сложной и не требует многочисленных согласований, выявление и уточнение проблемы должно занять максимум неделю. Но старайтесь по возможности не ставить других в известность о сроках, которые вы стремитесь соблюсти, — это только добавит давления на вас. Если для вашего комфорта и прогресса требуется еще несколько дней, тем лучше.

Моя рекомендация? Дайте себе достаточно времени, чтобы уложиться в срок. Гораздо лучше пообещать меньше и перевыполнить обещание, чем сделать обратное.

Полезно сначала определить, сколько дней, по вашему мнению, займет проект в целом, а затем добавить 20% к этому количеству.

Чаще всего на анализ данных времени не хватает. И если вы столкнетесь с препятствиями и подумаете, что не успеете завершить работу к дате, о которой вы изначально договорились, не забудьте предупредить заказчика — он должен узнать об этом как можно раньше. Информирование людей укрепит доверие между вами и другими участниками проекта и сделает их вашими единомышленниками. […]

В рубрике «Открытое чтение» мы публикуем отрывки из книг в том виде, в котором их предоставляют издатели. Незначительные сокращения обозначены многоточием в квадратных скобках. Мнение автора может не совпадать с мнением редакции.